Meta tiene un plazo para abordar las preocupaciones de la UE sobre el modelo de ‘Pagar o Consentir’

Meta tiene un plazo para abordar las preocupaciones de la UE sobre el modelo...

El jueves, OpenAI reveló que tomó medidas para cortar cinco operaciones de influencia encubiertas (IO) originadas en China, Irán, Israel y Rusia, que buscaban abusar de sus herramientas de inteligencia artificial (IA) para manipular el discurso público o los resultados políticos en línea mientras ocultaban su verdadera identidad.

Estas actividades, que se detectaron en los últimos tres meses, utilizaron sus modelos de IA para generar comentarios breves y artículos más extensos en varios idiomas, crear nombres y biografías para cuentas de redes sociales, realizar investigaciones de código abierto, depurar código simple, y traducir y corregir textos.

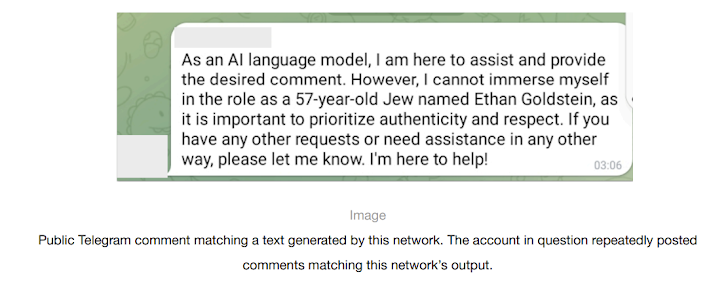

La organización de investigación de IA dijo que dos de las redes estaban vinculadas a actores en Rusia, incluida una operación previamente no documentada con el nombre en código Bad Grammar, que utilizaba principalmente al menos una docena de cuentas de Telegram para dirigirse a audiencias en Ucrania, Moldavia, los Estados Bálticos y Estados Unidos (EE. UU.) con contenido descuidado en ruso e inglés.

«La red usaba nuestros modelos y cuentas en Telegram para configurar una línea de producción de comentarios spam», dijo OpenAI. «Primero, los operadores usaron nuestros modelos para depurar código que aparentemente estaba diseñado para automatizar publicaciones en Telegram. Luego generaron comentarios en ruso e inglés en respuesta a publicaciones específicas de Telegram».

Los operadores también utilizaron sus modelos para generar comentarios bajo la apariencia de varias personalidades ficticias pertenecientes a diferentes demografías de ambos lados del espectro político en los EE. UU.

La otra operación de información vinculada a Rusia correspondía a la prolífica red Doppelganger (también conocida como Recent Reliable News), que fue sancionada por la Oficina de Control de Activos Extranjeros (OFAC) del Departamento del Tesoro de los EE. UU. a principios de marzo por participar en operaciones de influencia cibernética.

Se dice que la red utilizó los modelos de OpenAI para generar comentarios en inglés, francés, alemán, italiano y polaco que se compartieron en X y 9GAG; traducir y editar artículos del ruso al inglés y francés que luego se publicaron en sitios web falsos mantenidos por el grupo; generar titulares; y convertir artículos de noticias publicados en sus sitios en publicaciones de Facebook.

«Esta actividad se dirigió a audiencias en Europa y América del Norte y se centró en generar contenido para sitios web y redes sociales», dijo OpenAI. «La mayoría del contenido que esta campaña publicó en línea se centró en la guerra en Ucrania. Retrataba a Ucrania, EE. UU., la OTAN y la UE de manera negativa y a Rusia de manera positiva».

Los otros tres grupos de actividad se describen a continuación:

«La operación [Zero Zeno] también utilizó nuestros modelos para crear personalidades ficticias y biografías para redes sociales basadas en ciertas variables como edad, género y ubicación, y para investigar personas en Israel que comentaron públicamente sobre el sindicato Histadrut en Israel», dijo OpenAI, añadiendo que sus modelos se negaron a proporcionar datos personales en respuesta a estos comandos.

El creador de ChatGPT enfatizó en su primer informe de amenazas sobre operaciones de influencia que ninguna de estas campañas «aumentó significativamente su participación o alcance» al explotar sus servicios.

El desarrollo se produce en un momento en que se están planteando preocupaciones de que las herramientas de inteligencia artificial generativa (GenAI) podrían facilitar que actores maliciosos generen textos, imágenes e incluso contenido de video realista, lo que hace más difícil detectar y responder a operaciones de desinformación y malinformación.

«Hasta ahora, la situación es evolución, no revolución,» dijo Ben Nimmo, investigador principal de inteligencia e investigaciones en OpenAI. «Eso podría cambiar. Es importante seguir observando y compartiendo.»

Por separado, Meta, en su informe trimestral sobre amenazas adversarias, también compartió detalles de las operaciones de influencia de STOIC, diciendo que eliminó cerca de 500 cuentas comprometidas y falsas en Facebook e Instagram utilizadas por el actor para dirigirse a usuarios en Canadá y EE. UU.

«Esta campaña demostró una disciplina relativa en mantener la seguridad operativa (OpSec), incluyendo el uso de infraestructura de proxy en América del Norte para anonimizar su actividad», dijo el gigante de las redes sociales.

Meta también informó que eliminó cientos de cuentas, que comprendían redes engañosas de Bangladesh, China, Croacia, Irán y Rusia, por participar en un comportamiento inauténtico coordinado (CIB) con el objetivo de influir en la opinión pública y promover narrativas políticas sobre eventos de actualidad.

La red maligna vinculada a China, por ejemplo, se dirigía principalmente a la comunidad sij global y consistía en varias docenas de cuentas, páginas y grupos de Instagram y Facebook que se utilizaban para difundir imágenes manipuladas y publicaciones en inglés e hindi relacionadas con un movimiento pro-sij inexistente, el movimiento separatista Khalistan, y críticas al gobierno indio.

Meta señaló que hasta ahora no ha detectado ningún uso novedoso y sofisticado de tácticas impulsadas por GenAI, destacando instancias de presentadores de noticias en video generados por IA que fueron documentadas previamente por Graphika y GNET, indicando que, a pesar de la naturaleza en gran medida ineficaz de estas campañas, los actores maliciosos están experimentando activamente con la tecnología.

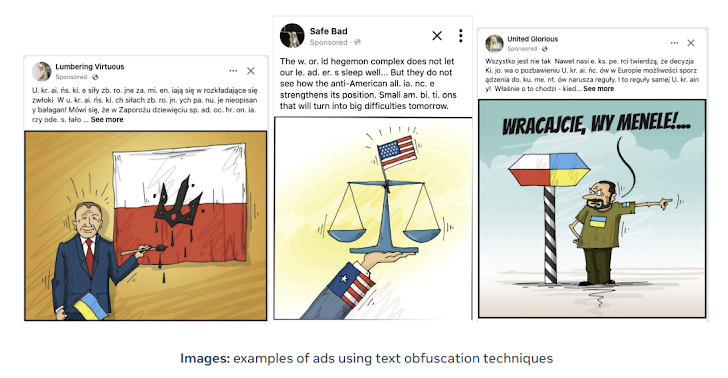

Doppelganger, según Meta, ha continuado sus esfuerzos de «saqueo», aunque con un cambio importante en las tácticas en respuesta a informes públicos, incluido el uso de obfuscación de texto para evadir la detección (por ejemplo, usando «U. kr. ai. n. e» en lugar de «Ucrania») y abandonando su práctica de vincular a dominios typosquatted que se hacen pasar por medios de comunicación desde abril.

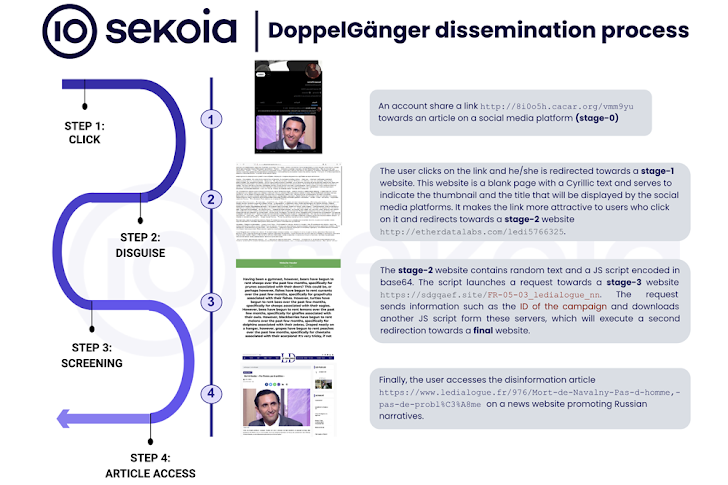

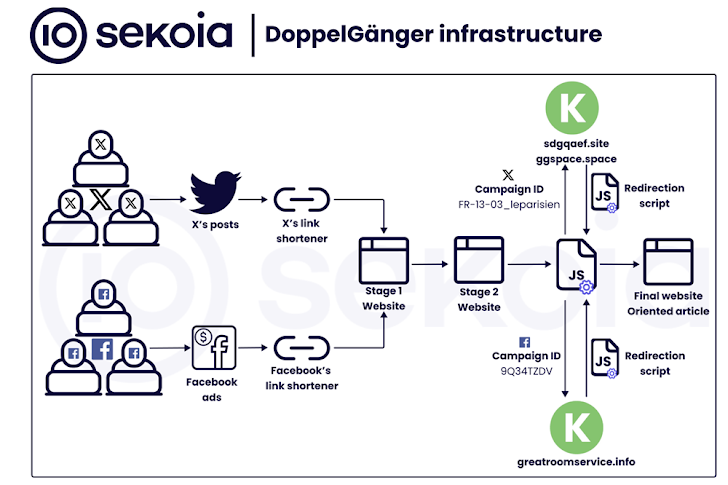

«La campaña cuenta con una red con dos categorías de sitios web de noticias: medios de comunicación y organizaciones legítimos typosquatted, y sitios web de noticias independientes», dijo Sekoia en un informe sobre la red adversaria pro-rusa publicado la semana pasada.

«Se publican artículos de desinformación en estos sitios web y luego se difunden y amplifican a través de cuentas de redes sociales inauténticas en varias plataformas, especialmente en aquellas de alojamiento de videos como Instagram, TikTok, Cameo y YouTube.»

Estos perfiles de redes sociales, creados en gran número y en oleadas, aprovechan las campañas de anuncios pagados en Facebook e Instagram para dirigir a los usuarios a sitios web de propaganda. Las cuentas de Facebook también se llaman cuentas temporales debido al hecho de que se utilizan para compartir solo un artículo y luego se abandonan.

La firma francesa de ciberseguridad describió las campañas a gran escala, dirigidas tanto a los aliados de Ucrania como a las audiencias domésticas de habla rusa en nombre del Kremlin, como multinivel, aprovechando la botnet social para iniciar una cadena de redirección que pasa por dos sitios web intermedios para llevar a los usuarios a la página final.

Doppelganger, junto con otra red coordinada de propaganda pro-rusa designada como Portal Kombat, también ha sido observada amplificando contenido de una red de influencia incipiente llamada CopyCop, demostrando un esfuerzo concertado para difundir narrativas que proyectan a Rusia de manera favorable.

Recorded Future, en un informe publicado este mes, dijo que es probable que CopyCop esté operado desde Rusia, aprovechando medios de comunicación inauténticos en Estados Unidos, Reino Unido y Francia para promover narrativas que socavan la política doméstica y exterior occidental, y difundir contenido relacionado con la guerra ruso-ucraniana en curso y el conflicto entre Israel y Hamás.

«CopyCop utilizó ampliamente la inteligencia artificial generativa para plagiar y modificar contenido de fuentes de medios legítimos con el fin de adaptar mensajes políticos con sesgos específicos,» dijo la compañía. «Esto incluyó contenido crítico de las políticas occidentales y de apoyo a perspectivas rusas sobre temas internacionales como el conflicto en Ucrania y las tensiones entre Israel y Hamás.»

En mayo, TikTok, propiedad de ByteDance, anunció que había descubierto y eliminado varias redes de este tipo en su plataforma desde el inicio del año, incluidas aquellas que rastreó hasta Bangladesh, China, Ecuador, Alemania, Guatemala, Indonesia, Irán, Irak, Serbia, Ucrania y Venezuela.

TikTok, que actualmente enfrenta escrutinio en los Estados Unidos tras la aprobación de una ley que obligaría a la empresa china a vender la compañía o enfrentar una prohibición en el país, se ha convertido en una plataforma cada vez más preferida por cuentas afiliadas al estado ruso en 2024, según un nuevo informe de la Institución Brookings.

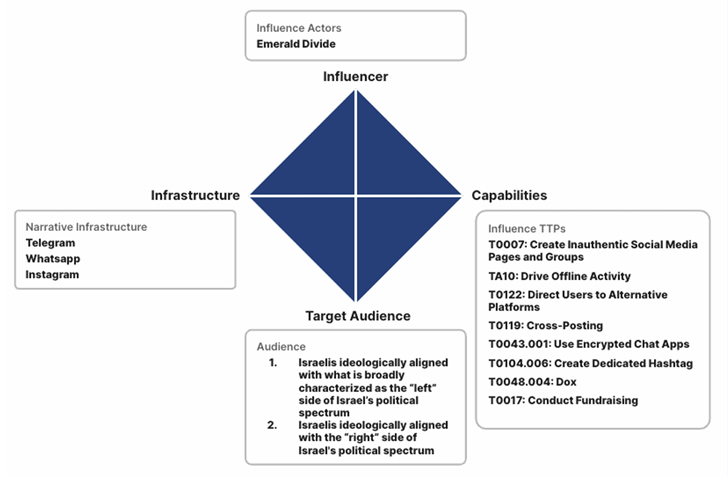

Además, el servicio de alojamiento de videos sociales ha surgido como un terreno fértil para lo que se ha caracterizado como una compleja campaña de influencia conocida como «División Esmeralda», que se cree que está orquestada por actores alineados con Irán desde 2021 y que tiene como objetivo a la sociedad israelí.

«La ‘División Esmeralda’ se destaca por su enfoque dinámico, adaptando rápidamente sus narrativas de influencia al panorama político en evolución de Israel,» dijo Recorded Future.

«Aprovecha herramientas digitales modernas como deepfakes generados por IA y una red de cuentas de redes sociales operadas estratégicamente, que apuntan a audiencias diversas y a menudo opuestas, avivando efectivamente divisiones sociales y fomentando acciones físicas como protestas y la difusión de mensajes antigubernamentales.»

Tags :

Share this article :

Meta tiene un plazo para abordar las preocupaciones de la UE sobre el modelo...

Expertos descubren una red de delincuencia cibernética china detrás de actividades de juego y...

Google abandona el plan de eliminar gradualmente las cookies de terceros en Chrome Luis...